2023年伊始,由ChatGPT的爆火引发了产业界和社会大众对于人工智能的热烈讨论,话题也延伸至AI是否可以取代人类,乃至通过什么方式取代人类,从电影中的故事情节到照进现实似乎转瞬而来。

进入第三次发展浪潮的人工智能距今也已经有约30年,为何在近期集中爆发,并开始引发新一轮“科技大爆炸”?

除了强算法、大数据量的支撑,AI的跨越式升级更与大算力的供给和提升息息相关。

以GPT-3为例,其参数规模达到1750亿,在训练阶段,总算力消耗约为3640 PF-days,假如每秒计算一千万亿次,需要计算3640天。显然,这样的算力规模是以往难以想象的。

这也驱动大规模、高算力、高密度的数据中心发展步入了快车道,数据中心正在从云计算时代走向AI时代,数据中心基础设施产生巨大变化。举例来说,存储介质从机械硬盘(HDD)演进到闪存盘(SSD),来满足数据的实时存取要求,存储介质时延降低了不止100倍;为了满足数据高效计算的诉求,业界已经在采用GPU以及专用的AI芯片,推动处理数据的能力提升了100倍以上。

它们追求的目标是不断将数据的高效处理推向极致,然而作为数据中心三大件之一的网络是否能够进行关键支撑,则同样十分重要。

事实是,数据中心网络面临的挑战十分巨大。

AI时代的数据中心,来自网络的挑战依然严峻

据IDC报告显示,当前主流数据中心以太网占比超过95%,但传统以太网在AI算力训练等应用下,吞吐量、时延及丢包方面表现并不出色。

AI场景下海量的参数分布于各个服务器之间,同步调用容易出现由于网络HASH负载分担不均而导致的吞吐下降,从而引发AI训练性能整体下降等问题。此外,大规模算力环境下的网络时延问题也是当今数据中心所面临的“紧箍咒”之一。

传统数据中心以太网更擅长相对较大容量的持续数据传输,日常“交互”相关工作并不是很多,但AI等相关应用则会将任务拆分成更小的粒度,更多地依赖于集群算力。这时,庞大的分布式系统使得服务器之间交互的消息长度猛增,原来一条消息经过1、2台服务器的“打包”后长度增加不多,对于信息处理不会消耗太多资源;但现在则会出现数台甚至数十台服务器“打包”后的海量消息,解耦这些臃肿的消息包会占用更多资源,并进一步加剧网络拥塞。

同时受限于传统以太网的转发机制,海量大体积的信息包导致网络拥塞后,还会使计算效率下降。AI场景下,传统数据中心以太网网络吞吐低、转发时延大等一系列问题致使算力无法充分释放,成为瓶颈。

数据中心网络向超融合以太演进

数据中心网络面对如此复杂的挑战,有没有合适的解决之道?

超融合以太技术满足超大规模算力集群对高性能计算的需求,为数据中心网络的发展指明了方向。

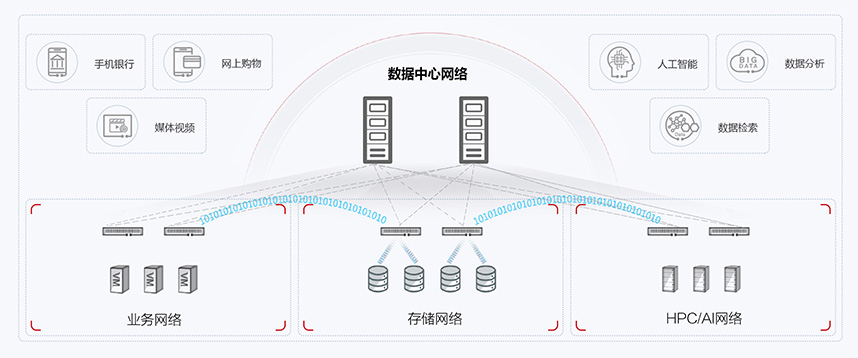

顾名思义,超融合以太技术是通过实现数据中心网络融合,将通用计算、存储和高性能计算统一承载在0丢包以太网技术栈上,打破传统分散架构限制,实现从三张网到一张网的融合部署,并推动无损网络向超融合网络架构演进,从而实现算力网络融合,充分释放算力。

相对于传统数据中心网络,超融合以太技术具备明显优势,这包括:可通过全新的智能拥塞控制算法,实现计算网络和存储网络融合混合调度;可通过全网负载均衡技术实现AI算力100%释放;可通过网络故障自愈,提升业务SLA保障等等。

点亮智能,华为超融合数据中心网络改变了什么?

超融合以太技术是AI时代的数据中心构建统一融合的网络架构的优选方案。基于此,华为基于多年数据中心网络成功实践的经验,推出了超融合数据中心网络方案。

- 助力AI场景下的数据中心网络“0丢包、低时延、高吞吐”

基于开放以太网,华为超融合数据中心网络首先满足了AI时代所需要的下一代数据中心网络的三个核心指标:0丢包、低时延、高吞吐。

说到这,我们或许很容易想到RDMA(Remote Direct Memory Access)技术。的确,RDMA的特点在于能够解放CPU,并实现内存互访、提升数据传输吞吐量、降低响应时间并支持更多网络拓扑结构,是分布式系统下的高效率解决方案。也正是在RDMA的支援下,才能让数据中心网络实现微秒级低时延、高吞吐量、低丢包率等特征。

但作为承载RDMA的两种方案——专用InfiniBand网络和传统IP以太网络来说,都有各自的缺点,InfiniBand网络架构封闭、运维复杂、价格昂贵,传统IP以太网则对网络丢包异常敏感。

扬长避短,华为超融合数据中心网络使用独创的iLossless智能无损算法,通过流量控制技术、拥塞控制技术和智能无损存储网络技术三大关键技术的相互配合,提前预防PFC死锁的发生、缓解/解除拥塞、实现对主机的快速管控,从而达到构建无损以太网络,解决传统以太网络拥塞丢包的问题。

体现在网络架构上,华为基于CLOS组网模型构建基于CloudEngine系列交换机的Spine-Leaf两级智能架构:计算智能和网络智能结合、全局智能和本地智能协同,共同打造无损低时延的数据中心网络。利用架构创新和上述一系列的技术集合为RoCE(RDMA over Converged Ethernet)v2流量提供“无丢包、低时延、高吞吐”的网络环境,满足RoCEv2应用的高性能需求。

- 网络级负载均衡算法,释放AI算力

华为超融合数据中心网络解决的另一大挑战则是在AI集群训练过程中出现网络负载不均导致的整网吞吐下降问题。在此方面,华为创新推出了网络均衡技术NSLB,它面向AI训练场景量身打造,根据该场景下的流量特征,通过将搜集到的整网信息作为创新算路算法的输入,从而得到最优的流量转发路径。

形象地说,NSLB技术类似于为拥有多条跑道的超大型机场打造了一个智慧调度系统,让飞机在多条跑道同时起飞降落时,不会互相冲撞,同时满足最大游客吞吐量。在AI训练场景下,实现整网流量100%的均衡度和AI训练性能的提升。

- 推动智能网络运维和故障自愈

在网络运维和故障自愈方面,华为超融合数据中心网络方案还引入了智能分析平台iMaster NCE-FabricInsight,基于全局采集到的流量特征和网络状态数据,结合AI算法,对未来的流量模型进行预测,从全局的视角,实时修正网卡和网络的参数配置,解决了传统的FC专网和IB专网的运维难题。

同时,华为提出了一种基于网络设备数据面的链路故障快速自愈技术DPFR (Data Plane Fast Recovery),该技术基于数据面处理硬件可编程能力构建。DPFR从传统的基于控制面软件协议的收敛方式演进到基于数据面硬件极速感知故障和快速换路的收敛方式,3个步骤即可切换链路,可达到亚毫秒级(<1ms)的收敛速度,从而使得对业务性能的影响降至最低。

至此,华为超融合数据中心网络面向AI业务场景,能够助力用户打造一张具备端到端业务性能提升、成本降低、支持智能运维等多重价值的网络。拿性能提升举例来说,据国际权威第三方独立测试机构EANTC测试结论,使用华为超融合数据中心网络可以在HPC场景下最高降低44.3%的计算时延,在分布式存储场景下提升25%的IOPS能力,且所有场景保证网络0丢包。

小结

所以,华为超融合数据中心网络的明显优势让AI场景下的网络不再有性能短板,也不必在InfiniBand网络的高成本和传统IP以太网的开放但低性能之间做出纠结选择,华为超融合数据中心网络带来的网络变革让“鱼与熊掌”两者兼得。

从大的环境看,人工智能已是不可逆转的技术变革趋势,大有万物皆可AI之势,诸多行业开始了大胆尝试,毫无疑问,AI时代的到来将进一步助推千行百业的数字化升级。

与之相匹配的算力、算法等各种新技术层出不穷。从国内来看,无论是东数西算、人工智能计算中心,还是全国一体化大数据中心建设等如火如荼。作为底座,未来数据中心将朝着多云异构算力演进,要构建强大的算力,需要各类资源高度协同、深度融合,华为超融合数据中心网络无疑为AI演进带来新一波创新动力。